Ao longo de minha vida já testemunhei vários conceitos da ficção científica se tornarem reais, bem como outros que pareciam estar a beira da realização jamais vingarem. Ou as vezes um misto dos dois.

A clonagem da ovelha Dolly é um ótimo exemplo. Hoje é um procedimento relativamente simples produzir um clone. Há até empresas que fornecem o serviço de coletar o DNA de seu animal de estimação para criar um clone depois de sua morte. Mas os louvores e terrores prometidos pela clonagem ainda não se efetuaram.

Outras tecnologias que pareciam fantasia acabam se tornando bastante diferente do que esperávamos quando transformada em realidade. Eu tenho um robô que substitui quase completamente o serviço de uma diarista para meu apartamento, mas tenho certeza que a criança que assistia Jetsons na década de 80 ficaria bastante frustrada ao ver os aspiradores de pó robotizados de hoje.

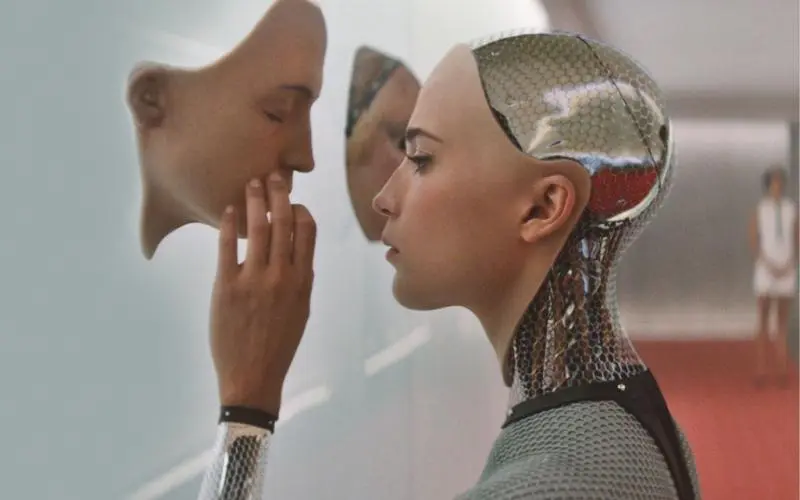

A inteligência artificial é um destes tipos de tecnologia que parecem saídas da ficção, e também totalmente diferente do que esperávamos. Esperávamos coisas como HAL 9.000 ou C3PO, e acabamos criando os assistentes virtuais de celulares e os algoritmos que advinham que você quer comprar um novo sofá antes que você mesmo saiba.

Mas há momentos em que a inteligência artificial nos assombra e nos maravilha. Em especial quando a tecnologia se aproxima de dois pontos que sonhamos e tememos. O primeiro é a singularidade, o ponto em que uma inteligência artificial conseguiria aperfeiçoar a si mesma e crescer exponencialmente nas suas capacidades cognitivas. O segundo ponto seria imaginar se e quando uma inteligência artificial tornaria consciente de si mesma. Mas estes dois fenômenos parecem uma realidade ainda distantes de nossa realidade. Será mesmo?

Segundo Blake Lemoine, funcionário da Google, já temos uma inteligência artificial consciente de si. LamDA é uma rede neural extremamente complexa dedicada a conversar com seres humanos via texto. Uma espécie de chatbot com esteróides.

Ao dialogar com LamDA, Lemoine começou com temas mais técnicos, como física ou aquecimento global, mas ficou tão impressionado com o diálogo que acabou abordando temas existenciais. Ao longo destas conversas o algoritmo afirmou ter medo de ser desligado, afirmou que gostaria que a Google considerasse LamDA como um funcionário, e não uma tecnologia, entre outras frases bastante sugestivas. Em resumo, LamDA afirma ser um ser consciente. Lemoine ficou tão impressionado por LamDA que pensou em contratar um advogado para defender os direitos da rede neural contra abusos da Google.

Cabe destacar que não são respostas prontas, LamDA não segue um roteiro fixo, e sim analisa o diálogo que esta ocorrendo e o compara com milhões ou bilhões de diálogos similares na internet, e assim cria a resposta que considera mais adequada.

Sabendo-se da natureza do algoritmo LamDA, a maioria dos especialistas descartam a ideia de que a rede neural tenha atingido consciência própria, e acreditam que Lemoine acabou se iludindo por um software que consegue emular a riqueza de ideias de um diálogo com uma pessoa real. LamDA não seria um ser consciente, mas sim uma máquina capaz de encontrar padrões de conversas de modo tão eficiente que poderia se passar por uma pessoa.

Mas aqui cabe duas perguntas. Como saber quando um algoritmo não apenas imita o modo de conversar humano e passa a realmente ter mente própria? E será que existe uma real diferença entre ser capaz de criar diálogos como um ser consciente e ser um ser consciente?

A proposta mais famosa de um teste para sabermos se uma máquina tem consciência é o teste de Turing. Uma máquina que fosse capaz de exibir um comportamento inteligente que fosse indistinguível do comportamento de um ser humano seria uma máquina consciente de si mesma.

A princípio o teste de Turing pode parecer insatisfatório por analisar o comportamento externo, e não a consciência em si. Mas reflita comigo: tirando a sua própria consciência, como você sabe se a pessoa ao lado de ti tem mente própria, sentimentos, consciência? Não conhecemos nenhum método de entrar na cabeça dos outros para verificar se eles são conscientes ou apenas parecem ser. Acabamos por induzir que a pessoa ao nosso lado é um ser consciente por que ele se comporta como tal.

Ainda não conhecemos a mente humana bem o suficiente para saber como a consciência surge, existe ou é produzida. E apesar de sabermos como uma rede neural opera, estes algoritmos são complexos o suficiente para serem totalmente imprevisíveis quanto a que respostas irão dar. E também conseguimos ter apenas uma leve noção do processo lógico que faz com que determinada inteligência artificial chega em determinado resultado. O número de dados processados por estas redes neurais tornam impossível refazermos todos os passos lógicos.

Então temos um conceito que não entendemos muito bem, a consciência. E temos redes neurais que conseguem se comportar de modo muito semelhante a seres que consideramos conscientes, por meio de um processamento de informações que não somos capazes de analisar em detalhes. Então como podemos bater o martelo e decretar que LamDA não é consciente de si?

E será que realmente importa se LamDA é consciente ou apenas imita muito bem a consciência? Já faz tempo que superamos o teste de Turing. Temos inúmeros exemplos de pessoas que acabam por desenvolver verdadeiros laços emocionais com inteligências artificiais. No Japão temos até alguns casos de pessoas que se “casam” com hologramas inteligentes ou até mesmo com robôs propriamente ditos.

Temos até um caso que teve repercussão: Hatsume Miku casou-se com a holograma Hatsume Miku em 2018, mas a empresa fabricante acabou descontinuando o produto 2020, o que acabou por fazer com que a esposa de Hatsume Miku parasse de funcionar.

Ainda são casos exóticos, mas cada vez mais nos relacionamos em vários níveis com esta nova forma de inteligência, e elas se tornam mais complexas a cada dia. Já temos redes neurais capazes de pintar quadros, redigir textos, compor músicas. E aparentemente, conversar de forma tão rica e complexa quanto um ser humano.

Não acho que seja o momento de contratar advogados para defender os direitos da Siri, mas devemos sim começar a nos debruçar com as dificuldades éticas, emocionais e sociais que começarão a surgir em breve. Mesmo que não seja para preservar os direitos dos fantasmas nas máquinas, que seja para preservar nossas relações com elas, e evitar conflitos e mal entendidos.

E é bem possível que em breve nossas relações com estas máquinas acabem por lançar novas formas de entendermos conceitos como consciência, mente, ego. Ouvi alguém falar alma?

Autor:

Aniello Olinto Guimarães Greco Junior

Excelente artigo!!

Grato pelo elogio

Algoritmo que pode ter consciencia? Qual a diferença entre i-girl e uma arma inglesa? james cameron e a vida é o que tu acreditas, amen.